制作AI视频时,你是否曾因角色中途换脸、镜头风格割裂或配音与画面错位而挫败?多场景叙事中,“一致性”的缺失是最令人头疼的核心难题。AI工具虽能生成画面,但缺乏系统性设计时,极易陷入“片段化产出”的困境。

本课程将分享一套“30秒3D叙事闭环”工作法——通过“角色元数据标准化+工具能力模块化”,把AI工具的随机性转化为可控的创作资产。无需专业团队或复杂剪辑,只需将工具特性与创作目标精准匹配,就能实现角色跨镜头的视觉统一与声音连贯性。

你将掌握:

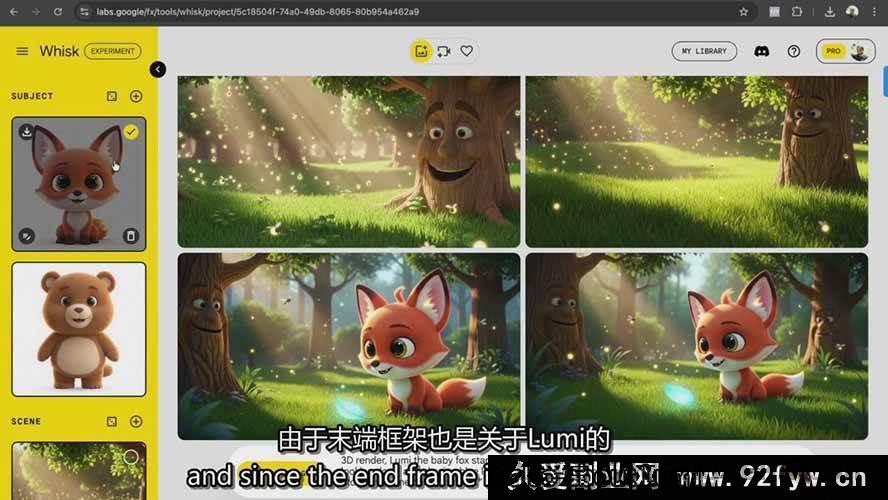

1. **视觉锚定技术**:设计“角色基准帧”,通过AI生成标准化3D角色,绑定面部特征、服饰比例等核心参数,从源头解决“角色跳变”问题;

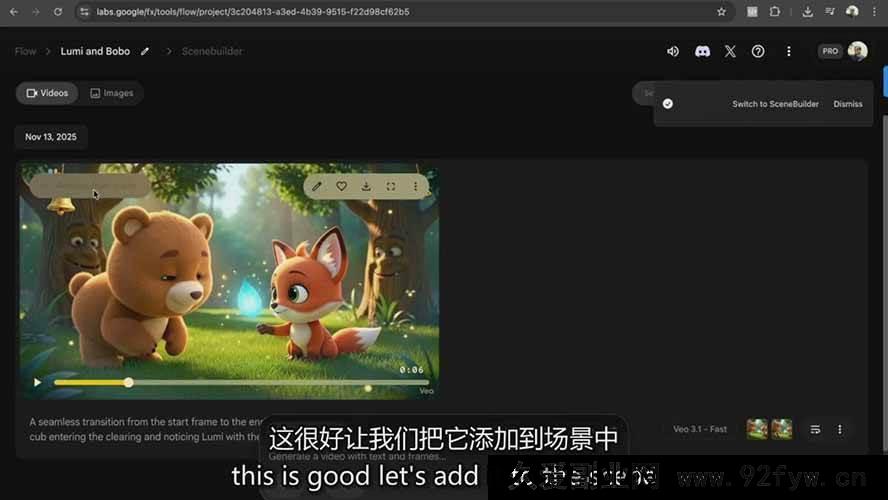

2. **动态生成逻辑**:用Google Flow的“关键帧-中间帧”联动机制,构建角色动作的“行为逻辑链”,避免机械运动感;

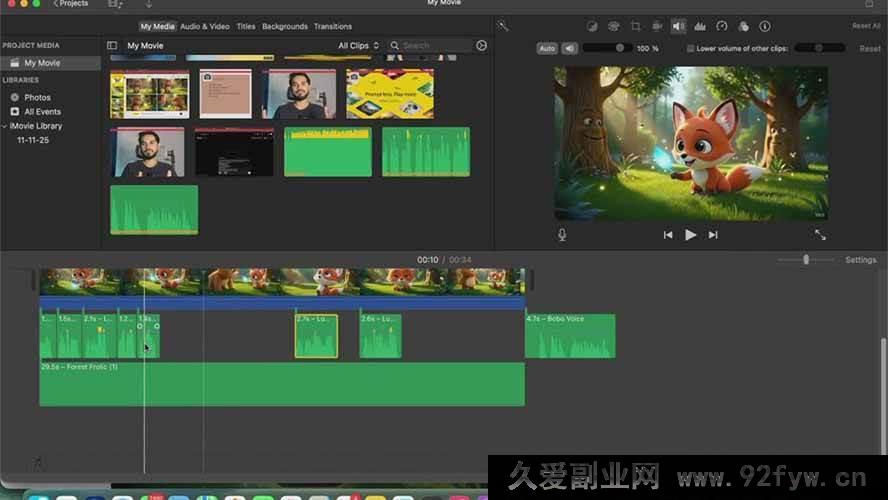

3. **叙事工程化**:借助ChatGPT的“结构化提示模板”,不仅生成台词,更输出“场景冲突点”“情绪转折点”等叙事节点,让镜头服务于故事;

4. **声纹校准系统**:通过ElevenLabs的“声线标签化”功能,将角色语音的声纹、情感、语速参数与元数据模板绑定,实现“音画同频”;

5. **多模态整合**:用“场景树状结构”串联各工具输出,形成“3D质感+电影节奏”的完整叙事。

课程不追求“超逼真”的表面效果,而是聚焦“可控性”的底层逻辑:如何通过“目标拆解-工具匹配-参数调试-结果验证”的闭环,让AI工具成为“创意脚手架”而非“创作黑箱”。每个步骤都按“零基础可操作”的标准拆解,即学即用。

适合人群覆盖:

– 想低成本探索AI影像创作的创意新手;

– 预算有限却需“角色故事”的独立创作者;

– 需“视觉化叙事”的营销内容策划者;

– 想突破2D局限、尝试3D风格的实验派;

– 被AI工具“随机输出”困扰的效率焦虑者。

课程终点,你将拥有一套“双角色全链路模板”——实现视觉、声音、动作的跨场景统一,为后续长片创作与创意叙事筑牢根基。没有“一键出片”的虚幻承诺,只有可复用的“AI影像生产系统”,让创意落地更高效、更可控。

下载地址: